グーグルのGeminiはどこがすごいのか?OpenAIのChatGPT、アンソロピックのClaude、主要3社の最新生成AIを徹底比較

【生成AI事件簿】図書館司書、敏腕編集者、校閲、エースライター、アイデア出し、文豪…それぞれに異なる個性と使い方

2025.12.12(金)

ここからは、JBpress Premium 限定です。

カンタン登録!続けて記事をお読みください。詳細はこちら

あわせてお読みください

NVIDIAの一強支配が崩れる日:GPU対TPU、計算インフラ覇権戦争の深層

生成AIが塗り替えようとしているAIインフラの地勢図

木寺 祥友

AIインフラが2大ブロック化する中、日本企業はどのような選択をすべきか

安定性か省エネか、GPU対TPUの対決場面が今後急増へ

木寺 祥友

サム・アルトマンのコードレッドが示す、日本企業への最後通牒

経営の中枢に入り込んだAIがビジネスモデルの大転換迫る

木寺 祥友

AI地面師の登場も近いか?AIエージェントが詐欺集団の形成に成功、AI詐欺師たちが被害者を騙した恐怖の連携プレー

【生成AI事件簿】連携して詐欺を働くAIエージェントに人間は太刀打ちできず、AI詐欺師集団の脅威にどう対応すべきか

小林 啓倫

井上尚弥のサウジ世界戦「4950円」の視聴料は高いのか?高額化の一途を辿るスポーツ視聴、もはや金持ちだけのものか

【生成AI事件簿】月1890円だったDAZNは10年で4200円、アメフト視聴は月90ドル、すべてを追うには複数契約も不可欠

小林 啓倫

本日の新着

アマゾン、ブラウザー版アレクサで狙う「家庭用エージェント」市場の開拓

アレクサの「脱・AIスピーカー依存」とマルチモーダル化の影響

小久保 重信

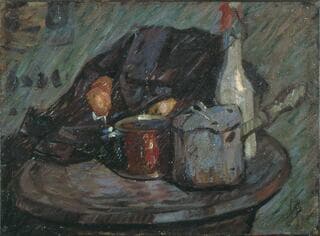

若き芸術家を支えた「新宿中村屋」、近代日本を代表する洋画家・中村彝(つね)との深い縁を感じる1枚

SOMPO美術館にて「開館50周年記念 モダンアートの街・新宿」が開幕

川岸 徹

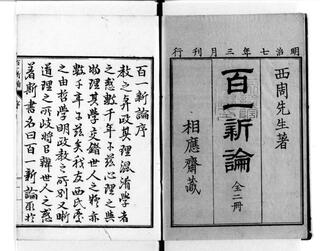

オランダ留学から帰国した西周、開成所教授から徳川慶喜の側近へ、著書『百一新論』の歴史的意義

幕末維新史探訪2026(4)近代日本の礎を築いた知の巨匠・西周―その生涯と和製漢語④

町田 明広

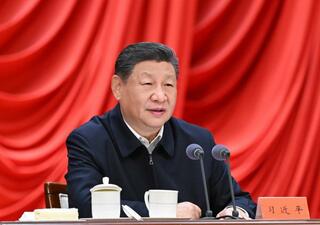

ドナルド・トランプの冒険主義におののく中国、次はどう出るべきか?

The Economist

日本再生 バックナンバー

明日メシを食うカネがない!金欠派遣高齢者が年金事務所や社会福祉協議会、区役所をはしごしてゲットしたもの

若月 澪子

麻雀にハマり、家と仕事を失った中高年男性が辿り着いた介護職、そこで彼が見た女性社会の掟とは

若月 澪子

なぜ私の職場はこんなにも憂鬱なのか?心理学が明かす価値観の衝突と、憂鬱からあなたを解放する「首尾一貫感覚」

関 瑶子 | 舟木 彩乃

中高生「暴力動画」が映すのはむしろ大人社会の闇…ネットで事実を知る学校の無力、関係先凸りSNSに晒す歪んだ正義

青沼 陽一郎

【関連銘柄も爆上がり】2035年に6兆円市場に、AI業界が注力するフィジカルAI、日本はロボット大国の地位を守れるか

小林 啓倫

「連休で仕事が休みになっちゃって。3000円くらい貸してもらえませんか」大型連休で干からびる派遣高齢者の日常

若月 澪子