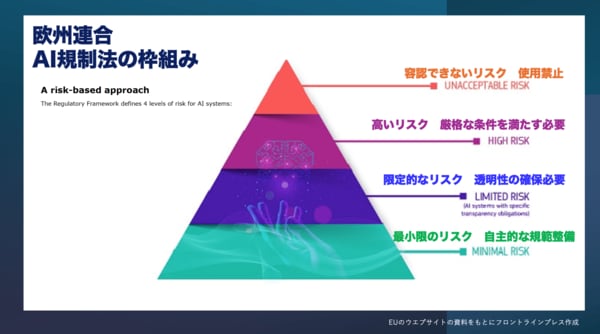

欧州が定めた4段階の危険度

EUのAI規制法は、使用目的や内容によってAIの危険度を4つのレベルに分類し、それぞれのレベルに応じた規制を設けました。

最も厳しいランクは「容認できないリスクを持つAI」で、これに該当するものは全面的に使用が禁止されます。

例えば、個人の行動を操作するもの、個々人の信用格付け(ソーシャルスコアリング)、年齢・障がい・経済状況など個人の弱みにつけ込むものなどが、このレベルに該当します。政治・宗教・思想・性的指向・人種など極めてセンシティブな個人の情報を利用して人々を分類するAI、インターネットや監視カメラからの顔画像の収集、職場・教育機関で人々の感情を認識するAIなども使用できません。

次のランクが「高リスクを持つAI」です。これに該当するAIは全面禁止ではありませんが、法の要件を厳格に満たしていなければなりません。教育機関での入学者選抜やクラス分け、職場での採用や評価などに使う場合、さらに従業員の行動監視・分析のためのAIなどが該当します。

「限定的なリスクのAI」では、透明性の確保のみが使用の条件となります。該当するのは生成AIを使用した動画や音声、チャットボットなどです。例えば、ディープフェイク技術を使用したコンテンツを提供する場合は、生成AIを使っていることを明示する必要が生じます。

「最小リスクのAI」では自主的な使用規範の作成などが求められます。ゲームなどにAIを組み込む場合が該当します。

一方、AIの基盤モデルを開発した企業に対しては、著作権を侵害していないかどうかを厳しく自己チェックし、AIの学習過程で著作権のあるコンテンツを使った場合などにはそのデータを開示する義務が生じます。

重い制裁金を課すのも、この規制法の目玉です。違反した事業者には、最大3500万ユーロ(約56億円)もしくは年間売上高の7%のどちらか高い方という巨額の制裁金が課せられます。

AI規制法の全面的な適用は2026年になる見込みです。EU全域で適用され、域内で活動する外国企業も対象。AIによるコンテンツをEU内で提供する場合も法の適用対象になるため、日本企業も無関係ではありません。