兵庫県知事選でも飛び交った偽情報、デマや陰謀論に対するAIボットの反論はどこまで効果的か?

【生成AI事件簿】最新研究で判明、ボットによるカウンタースピーチが逆効果の場合も

2024.11.28(木)

ここからは、JBpress Premium 限定です。

カンタン登録!続けて記事をお読みください。詳細はこちら

あわせてお読みください

識者が改めて分析、SNSパワーで勝利した斎藤元彦知事、貢献したのはPR会社ではなくやはり立花孝志氏

米重 克洋

全米が震撼!Xで拡散された超大物アイドルのディープフェイク・ポルノの衝撃

【生成AI事件簿】技術進化の負の側面、ディープフェイクにどう対応すべきか

小林 啓倫

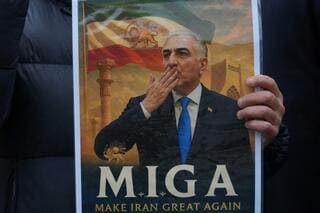

トランプ陣営は生成AIやディープフェイクを選挙戦にどのように活用したのか?

【生成AI事件簿】大統領選で生成AIミームを兵器化したトランプ陣営、「移民がペットを食べる」の画像が示唆すること

小林 啓倫

銃乱射事件で殺されたウジ君が語り出す……AIで復活した故人を社会活動に参加させることはどこまで許されるか

【生成AI事件簿】再生ボタンを押すと語り出す事件・事故の被害者

小林 啓倫

亡くなったノーベル文学賞詩人を「復活」させたポーランドのラジオ局に批判殺到、何がマズかったのか?

【生成AI事件簿】故人を完璧に再現するデジタル・レザレクションの是非

小林 啓倫

本日の新着

地球の明日 バックナンバー

サイバー攻撃と一体化していた「マドゥロ拘束作戦」、驚くべき精密さだったカラカス停電はどのように遂行されたのか

小林 啓倫

フードデリバリーの不正行為というデマが広まったのはなぜか?3600万回以上のスクショが拡散された複合的な構図

小林 啓倫

YouTubeショートの3分の1が脳を腐らせるゴミ動画、AI生成の動画で億単位のカネが儲かる今の仕組みはおかしくない?

小林 啓倫

生物に影響を与える繁殖干渉とは?種を超えたオスの求愛が相手種を絶滅させる

岸 茂樹

【AIの人間観】争いや戦争など人間の「愚行の歴史」を学び続けるAIは人間をどのような存在として認識しているのか?

榎並 利博

世界史がめったに教えないソクラテス、プラトンの性的指向

市川 蛇蔵