生成AIに騙される弁護士がいまだに相次ぐ――裁判に架空の判例を提出した弁護士には制裁金の勧告

【生成AI事件簿】生成AIのハルシネーションに幻惑?AIチャットボットの回答を鵜呑みにしてはならない

2025.2.28(金)

ここからは、JBpress Premium 限定です。

カンタン登録!続けて記事をお読みください。詳細はこちら

あわせてお読みください

本格的に対策が求められる生成AI向け検索対策「GAIO」、企業は何をすればいいのか?

【生成AI事件簿】検索エンジンとはだいぶ異なるChatGPTの検索結果、SEOからGAIOにシフトして起きること

小林 啓倫

全米が震撼!Xで拡散された超大物アイドルのディープフェイク・ポルノの衝撃

【生成AI事件簿】技術進化の負の側面、ディープフェイクにどう対応すべきか

小林 啓倫

AIに関するCMが乱舞した今年のスーパーボウルでGoogleが赤っ恥、同社のCMで何が起きたのか?

【生成AI事件簿】Geminiが生成した情報に間違い、ノーチェックでの生成AI活用はやはり危険

小林 啓倫

「革命」とも叫ばれたディープシークの技術力に上がる疑問の声、指摘される「蒸留」とは一体どういうことか?

【生成AI事件簿】トランプ大統領がディープシークに敗北宣言?これから明らかにされるディープシークの秘密

小林 啓倫

「中国共産党の長所と短所を教えて」その回答に見るDeepSeekの課題と、生成AI業界にもたらす新たな革命

【生成AI事件簿】半導体業界の巨人を襲った「ディープシーク・ショック」とその本質

小林 啓倫

本日の新着

サイバー攻撃と一体化していた「マドゥロ拘束作戦」、驚くべき精密さだったカラカス停電はどのように遂行されたのか

【生成AI事件簿】サイバー空間での攻撃が現実空間での特殊部隊の作戦と同期した「マルチドメイン作戦」の完成形

小林 啓倫

日本と韓国が「ともに生きる」ために必要なものとは?日本の敗戦から80年間の日韓関係をアートで表現する意義

横浜美術館で「いつもとなりにいるから 日本と韓国、アートの80年」を開催

川岸 徹

ドンロー・ドクトリンの妄想、ドナルド・トランプの世界では強者が奪えるものを奪う

The Economist

【日韓首脳会談】韓国では「日本が東アジアで孤立している今こそ慰安婦や徴用工問題を前進させる好機」との世論大勢

李 正宣

イノベーション バックナンバー

唾液が認知症やがんの医療を変える!わずか1mlで早期発見が可能に、パーキンソン病など発症前からリスク判定も

竹林 篤実

AIでペットの気持ちが本当にわかるのか? 哲学者が考える「根本的な問い」とは

シンクロナス編集部

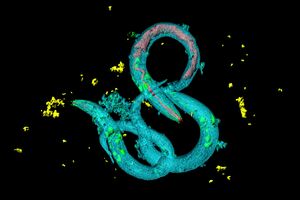

線虫の「老化」にみる驚くべき種の生存戦略、生殖機能がなくなったら集団のために自ら身を引く?

竹林 篤実

進化する“AI音楽”。生成AIが音楽シーンにもたらす変化とは? アメリカでは訴訟や法案提出も

シンクロナス編集部

ピンピンコロリの達人、ハダカデバネズミに学ぶ理想の生き方〜なぜ、老いもせず、衰えもせず、がんにもならないのか

竹林 篤実

なぜ国や自治体が惑わされる? 巧妙な「疑似科学」への向き合い方

シンクロナス編集部