2015年には、あるAIが1970年代のゲームセンターにあったビデオゲーム「ブロックくずし」のプレイをひとりで学習している。このAIは、ゲームのルールや戦略について何も聞かされていない。操作機能を与えられ、スコアを最大にすることで報酬を得ていただけだ。

AIが遊び方を覚えたことは驚くに当たらない。だが、AIはブロックの列に「トンネル」を作るテクニックを独力で編み出した。トンネルにボールを通して、ブロックの列を後ろからも崩していくという技だ。

人間の価値観を反映したAIは作れるのか?

ここで私が紹介している話は、どれもAI研究者にとっては目新しいものではないし、研究者の多くが今では、目標と報酬のハッキングを防ぐ方法を検討している。

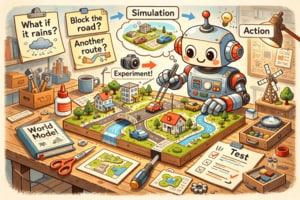

ひとつの解決策は、AIに文脈を教えることだ。研究では、目標整合性の問題を考慮しなければならないのと同様、「価値整合性」の問題も考慮しなければならない。人間の価値観を反映したAIを作るという課題だ。

これに対する解決策は、両極にある2つの枠組みで考えることができる。一方では、努力にふさわしい価値を明示的に指定することができる。これは現在でも、程度の差はありながら実現しているが、前述したようにハッキングの影響を受けやすい。

もう一方では、人間の行動を観察したり、人類の著作物つまり歴史、文学、哲学などを入力として取り込んだりすることで、人間の価値観を学習するAIを作ることもできる。これはまだ何年も先のことで、おそらくは広いAIの機能になるだろう。現在の研究のほとんどは、この両極の間で揺れ動いている。

人間のこれまでの価値観やいま観察される価値観にAIを適合させると、どんな問題が生じるかは容易に想像できる。AIはいったい誰の価値観を反映すればいいのか? ソマリアの男性か、シンガポールの女性か。それとも、どうなるか分からないが両者の平均値か。

人間の価値観は矛盾だらけであり、ある価値観に沿って生きようとしてすら、一貫性に欠けてしまう。ひとりひとりの個人の価値観は不合理だったり不道徳だったりするかもしれないし、誤った情報に基づいている可能性もある。歴史、文学、哲学には不合理、不道徳、誤りが満ちあふれている。人間は往々にして、理想を反映した適切な見本とはほど遠いのである。

攻撃側も防御側も同じAI技術を使える

ハッキング対策として特に有効なのは、脆弱性を見極めること、つまりハックがシステムの損壊に使われる前に発見し、パッチを当てることだ。これに、AI技術を全面的に応用できる。AIは超人的なスピードで動作できるのだから。