AWS最大の年次会合「AWS re:Invent」で講演するマット・ガーマンCEO(12月3日、写真:AP/アフロ)

AWS最大の年次会合「AWS re:Invent」で講演するマット・ガーマンCEO(12月3日、写真:AP/アフロ)

米アマゾン・ドット・コム傘下のクラウド最大手、アマゾン・ウェブ・サービス(AWS)が、AI戦略の「第2幕」を鮮明にしている。

12月上旬に米ラスベガスで開催した年次開発者会議「re:Invent 2025」で同社が打ち出したのは、圧倒的なコスト競争力を持つ自社製半導体と、人の介入なしに長時間稼働する「自律型AIエージェント」の投入だった。

AIモデル開発での出遅れが指摘されてきた同社だが、インフラ(半導体)からアプリケーション(エージェント)までを垂直統合で囲い込む「フルスタック戦略」で、米エヌビディア(NVIDIA)や米マイクロソフトなど競合への対抗姿勢を強めている。

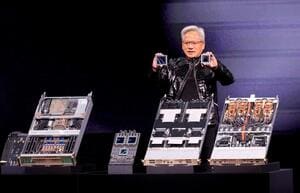

「脱・エヌビディア」への布石 自社チップ「Trainium3」投入

AWSが今回のイベントで最大の目玉としたのが、自社開発のAI学習・推論用半導体「Trainium3(トレーニアム3)」の一般提供開始だ。

同社初の3ナノ(ナノは10億分の1)メートルプロセスを採用したこのチップは、前世代と比較して演算性能を最大4.4倍、電力効率を4倍に高めたという(発表資料)。

狙いは明確だ。AI開発コストの劇的な削減である。

生成AIのモデルが巨大化する中、計算資源(コンピュート)のコストは企業にとって重い負担となっている。

AWSは、Trainium3を搭載したサーバー「UltraServer」を利用することで、同等のGPU(画像処理半導体)システムと比較して学習・運用コストを最大50%削減できると主張する。

汎用的なGPUとは異なり、AI処理に特化して設計された専用チップであることが、この効率性を生み出している。

既に米アンソロピックなどの有力AI企業が採用を決めた。

米ウォール・ストリート・ジャーナル(WSJ)によると、AI動画生成スタートアップの米デカルト(Decart)は、Trainium3を活用することで、GPUの半分のコストで4倍の推論速度を実現したという。

AI半導体市場では米エヌビディアが依然として圧倒的なシェアを握る。

AWSもエヌビディア製の最新チップ「Blackwell(ブラックウェル)」搭載サーバーの導入を発表するなど協力関係は維持しているが、自社チップの性能向上を急ぐ背景には、エヌビディアへの依存度を下げ、調達コストと供給リスクをコントロールしたい思惑がある。

今回、次世代品となる「Trainium4」の開発計画も併せて公表しており、独自路線を突き進む構えだ。