AIが普及したいま、「微分」の初歩は中学校で教えなさい!

子供の興味を引き出す「スケボー」などの応用問題

2025.6.8(日)

ここからは、JBpress Premium 限定です。

カンタン登録!続けて記事をお読みください。詳細はこちら

あわせてお読みください

AIを活用して俳句を作る、これが「邪道」ではなく「正統」な理由

正岡子規も切望した19世紀最新技術「辞書」の電子化、金子兜太も苦吟した推敲の本質

伊東 乾

大阪万博で大量発生中のユスリカ対策、実は殺虫剤より効果的な小魚

1950年代に八丈小島で奇病「バク」を根絶したそのパワー

伊東 乾

トランプ政権のハーバード攻撃は日本復活の絶好のチャンス、優秀な留学生受け入れ競争に負けるな

「コスモポリタン」だけがチャンスを生かすことができる

伊東 乾

殺虫剤メーカーの協力で「いのち輝く」とは、大阪万博の悲しいアイロニー

5月25日「山本理顕シンポジウム」とロールモデル製造協力「東京大学」の「罪と罰」

伊東 乾

東大で「風俗接待」疑惑発覚、政府派遣のコンプライアンス担当者の責任重大

隠蔽体質は問題を大きくするだけ、今こそ東大は襟を正せ

伊東 乾

本日の新着

歯の治療費250万、孫へ贈与が500万…退職金が「蒸発」し、年金が「枯渇」する恐怖

「そこそこの貯蓄」があっても安心できない、年金生活者を襲う想定外の出費

森田 聡子

生産終了が迫るアルピーヌ A110と賢者の選択

大谷 達也

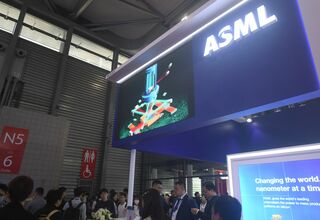

「中国が『EUV露光装置』試作機完成」の衝撃…世界の半導体秩序は抜本的に書き換えられてしまうのか?

莫大なカネとヒトをつぎ込んだファーウェイ、中国半導体版「マンハッタン計画」の行方

湯之上 隆

高市首相の“安倍流”電撃解散案の衝撃、大義は「積極財政」の是非か、党内制圧と国民民主連立入りで狙う盤石の権力

身内も欺く「最強の不意打ち解散」へ、自民党単独過半数の獲得が焦点

市ノ瀬 雅人

世界の中の日本 バックナンバー

なぜ古代日本では遷都が繰り返されたのに、平安京で終わったのか?古代日本の宮殿と遷都が映し出す権力と政治

関 瑶子

「ヒロシマのタブー」避け、硬直化し定型化した語りで「核兵器なき世界」を実現できるのか

宮崎 園子

2026年、重要性増す社会的情動スキルとステージマネジャー猪狩光弘の凄技

伊東 乾

AIのお試し期間は2025年で終了、2026年に顕在化する5つのトレンドとAIで稼ぐ企業・コストになる企業を分ける差

小林 啓倫

子供の能力を伸ばす「非認知能力」教育の誤解と正解

伊東 乾

反ムスリム土葬墓論はなぜ間違っているのか?そもそも神道は土葬が前提、土葬が公衆衛生上良くないという論法も乱暴

鵜飼 秀徳