【人はどこまで悪趣味になるのか?】AIを使って故人を蘇らせる生成ゴーストが急増!SNSのネタとして消費される死者

【生成AI事件簿】大炎上したダイアナ妃とウィリアム王子のツーショット、殺された娘がAIキャラクターにされた事例も

2024.12.21(土)

ここからは、JBpress Premium 限定です。

カンタン登録!続けて記事をお読みください。詳細はこちら

あわせてお読みください

銃乱射事件で殺されたウジ君が語り出す……AIで復活した故人を社会活動に参加させることはどこまで許されるか

【生成AI事件簿】再生ボタンを押すと語り出す事件・事故の被害者

小林 啓倫

亡くなったノーベル文学賞詩人を「復活」させたポーランドのラジオ局に批判殺到、何がマズかったのか?

【生成AI事件簿】故人を完璧に再現するデジタル・レザレクションの是非

小林 啓倫

日本に迫られた踏み絵、原発回帰するか先端技術開発競争から脱落するか

生成AIがもたらす原発回帰は世界の潮流、日本投資の芽を摘むな

横山 恭三

【あのエヌビディアが出資】日本発のユニコーン企業「Sakana AI」が生み出した「AIサイエンティスト」とは何か?

【生成AI事件簿】エヌビディアに加えて日本のメガバンクも出資、評価額は2200億円に

小林 啓倫

トランプ陣営は生成AIやディープフェイクを選挙戦にどのように活用したのか?

【生成AI事件簿】大統領選で生成AIミームを兵器化したトランプ陣営、「移民がペットを食べる」の画像が示唆すること

小林 啓倫

地球の明日 バックナンバー

なぜAIエージェントに調査を頼むとイマイチな報告が上がってくるのか?AIのレポート精度を上げるプロンプトの特徴

小林 啓倫

次のAIのブレイクスルーも必ず人間の脳から生まれる、超知能AIシステムを開発するために必要な「心の理論」

長野 光

AIによる世論操作はより深く巧妙に、協調して動くAIチャットボットの群れが生み出す偽世論の脅威

小林 啓倫

ナショナリズムとは何か、どのような条件が揃うとナショナリズムが高揚するのか?世界に広がるナショナリズムの本質

長野 光 | 中井 遼

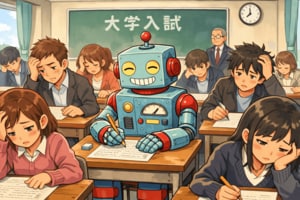

大学入学共通テスト・主要15科目の9科目で満点を獲得、生成AIが入試で満点を取る時代に大学はどう向き合うべきか?

小林 啓倫

竹中工務店はなぜ月面基地の検討を始めたのか?もはや一部の天才のものではない宇宙開発、既に手に届くところにある

関 瑶子 | 佐々木 亮