ハルシネーションについて対応を進めるChatGPTだが……(写真:Angga Budhiyanto/ZUMA Press Wire/共同通信イメージズ)

ハルシネーションについて対応を進めるChatGPTだが……(写真:Angga Budhiyanto/ZUMA Press Wire/共同通信イメージズ)

- 生成AIは回答を「知らない」とは答えず、無理やり回答しようとし、その回答が差も正答かのような表現で文章化する。「ハルシネーション」だ。

- ハルシネーションがただの誤答であればユーザーが気をつければ済むかもしれないが、悪意のある人間が悪用した場合はどうなるだろうか。

- ハルシネーションを活用した攻撃を避けるためには、どのような「幻覚」が起こりうるのか、その傾向を把握しておくことが第一歩だ。

(小林 啓倫:経営コンサルタント)

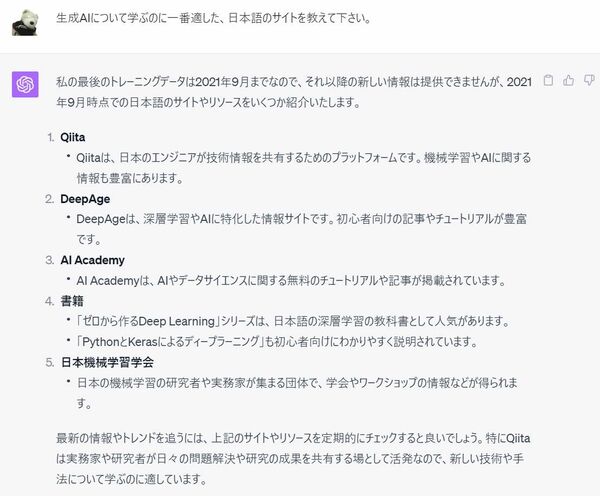

AIを学びたければ「日本機械学習学会」がお薦め

これからビジネスを、そして社会全体を大きく変えると期待されている生成AI技術。今から学びたいという方のために、どのようなウェブサイトが参考になるか、注目の生成AIの一つであるChatGPTに尋ねてみよう。

以下の画像はChatGPTの実際の回答だ。

なるほど、いくつか使えるサイトがあるようだ。また、ウェブサイトではないのだが、「日本機械学習学会」という学会もお薦めされている。研究者だけでなく実務者も集まり、ワークショップが開催されているという。これは良さそうだ――。

しかし残念ながら、この記事を執筆している9月9日の時点で、日本機械学習学会なる学会はGoogleで検索しても「一致はありません」という結果になる。

ただし、“日本機械学習学会”という完全一致でなければ、「人工知能学会」や「日本機械学会」などの学会がヒットする。「2021年_機械学習学会カレンダー」というページもあったようだが、現在はリンク切れとなっている。

これがいわゆる、生成AIの「ハルシネーション(幻覚)」問題だ。

ChatGPTは人間のように「考えて」いるわけではなく、単に与えられた質問に対して、統計的に正答となる可能性が少しでも高くなる単語を羅列しているに過ぎない。

そのため正解を知らなくても「知らない」とは答えず、無理やり回答しようとし、さらにその回答がさも正答かのように感じられる表現で文章化する。その結果、まるで本当かのように嘘をついてしまうことがあるのだ。

ChatGPTの名誉のために、他の文章生成AIでも確認してみよう。次ページの画像は、Googleの生成AIである「Bard(バード、吟遊詩人という意味)」で同じ質問をした結果だ。