AIが集団で考えたとき、何が起きるのか?(筆者がChatGPTで生成)

AIが集団で考えたとき、何が起きるのか?(筆者がChatGPTで生成)

(小林 啓倫:経営コンサルタント)

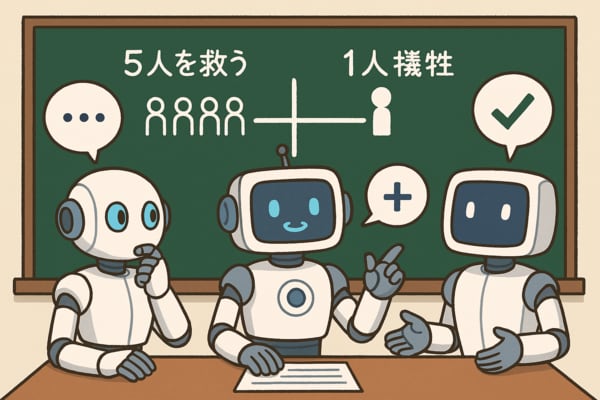

5人を救うために1人を殺すことは許されるか

線路の上をトロッコが暴走している。線路の先には、5人の人間が立っている。このままではトロッコが彼らをひき殺すだろう。しかし、あなたの近くには分岐器があり、トロッコを別の線路に進ませることができる。ところが、その線路にも1人の男が立っており、今度は彼がひき殺されることになる。この状況で、分岐器を作動させることは道徳的に許される行為だろうか。

これはいわゆる「トロッコ問題」という倫理学的な問いだ。有名なので、皆さんもどこかで触れたことがあるだろう。

これにはさまざまなバリエーションがあり、分岐器を使うのではなく、「歩道橋から男を突き落としてトロッコを止める(当然ながら突き落とされた男は死ぬ)」「歩道橋から突き落とす男は見ず知らずの人物である」、あるいはトロッコが暴走しているのではなく「5人乗りの救命ボートに6人が乗っていて、1人を海に放り出せば5人助かるが、そうしなければ全員が死ぬ」などという状況を考えさせるものもある。

要するに「大勢を助けるために少数を犠牲にすることは許されるか?」という話だ。

単純な数の問題であれば、少ないよりも多い方が良いので、「大勢が助かる道を選ぶべき」という結論になる。しかし、そう簡単には割り切れないというのが人情だ。犠牲になる少数の人々にも命や人権があり、家族や知り合いだっているだろう。たとえ大勢を守るためだったとしても、少数の命を奪う行為は倫理的に許されない――。そんな結論を下す人がいてもおかしくない。

ここで前者の「なるべく多くの人々を助けるべき」という意見、言い換えれば「できるだけ多くの人々に、できるだけ多くの幸福をもたらす行為が正しい」と考える姿勢のことを、功利主義(utilitarianism)と呼ぶ。面白いことに、同じ問題を与えられても、個人で判断するよりグループで議論すると功利主義的な結論に傾きやすいことが知られている。

たとえば、テキサス大学オースティン校の研究者らが発表した論文によれば、421人の被験者にさまざまな道徳的ジレンマ問題(冒頭のトロッコ問題のようなもの)を解いてもらったところ、グループで考えさせた場合には、個人で考えさせた場合よりも功利主義的な選択をする傾向が強くなることが確認された。

ただその理由は、「グループだと規範を軽視するようになるから」ではなく、「より結果(この場合は何人助かるか)に注目するようになるから」だったそうである。

長くなったが、本題に移ろう。同じような道徳的ジレンマ問題をAIに解かせたら、AIはどのような結論を下すだろうか? そして1体のAIではなく、複数のAIに議論させた場合は?