3rdtimeluckystudio/Shutterstock.com

3rdtimeluckystudio/Shutterstock.com

ビジネスや社会生活にAIが急速に普及するのに伴い、AIに関する倫理やガバナンスが注目を集めている。本連載では、Deloitte AI Instituteのグローバルリーダーが著した『信頼できるAIへのアプローチ』(ビーナ・アマナス著、森正弥・神津友武監訳/共立出版)より、内容の一部を抜粋・再編集。AIに潜む落とし穴、積極的に利用するために必要なリスク管理、そしてAIをいかに信頼できるものとして活用していくかを探る。

第2回目は、AIにバイアスがかかってしまう可能性とその原因を考える。

<連載ラインアップ>

■第1回 Deloitte AI Instituteのグローバルリーダーが考える「信頼できるAI」とは?

■第2回 AIに履歴書を読み込ませれば、優秀な人材を本当に素早く選び出せるか?(本稿)

■第3回 バイアスのあるデータで学習したAIが、ビジネスに与える深刻な影響とは?

■第4回 CEOは男性、秘書は女性?なぜ人間が作るデータにバイアスがかかるのか?

■第5回 AIを使うべきか使わぬべきか、リーダーとデータサイエンティストの責任とは?

※公開予定日は変更になる可能性がございます。この機会にフォロー機能をご利用ください。

<著者フォロー機能のご案内>

●無料会員に登録すれば、本記事の下部にある著者プロフィール欄から著者をフォローできます。

●フォローした著者の記事は、マイページから簡単に確認できるようになります。

●会員登録(無料)はこちらから

第2章 公平性と中立性

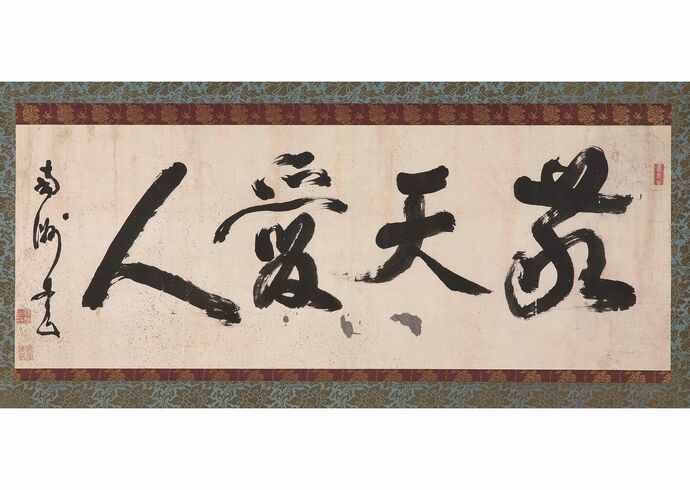

『信頼できるAIへのアプローチ』(共立出版)

『信頼できるAIへのアプローチ』(共立出版)拡大画像表示

多くの企業がそうであるように、BAM社においても高い技術力を持った従業員が不足していました。

BAM社には低迷している収益を立て直すための技術はあるものの、その技術を有効活用できる従業員がいなかったのです。そのため最高人事責任者であるVidya(ヴィジャ)は、人事部がより多くの応募者を募る必要があると考えていました。

BAM社はハイテクな機械を操作できる人材を必要としており、そのためには力ではなく知性が求められていたのです。Vidyaは、山のようにある履歴書や応募書類を整理するために、時折メンテナンスされていたもののあまり使用されていないAIシステムに目を付けました。

それは前任者が人事部に導入したもので、Vidya自身は従来の手作業による書類審査を好んでいたので使用することはありませんでしたが、今回はあまりにも書類の数が膨大であったため、手作業では全書類を素早く審査することができないと考えたのです。

Vidyaは、データチームやAIチームと十分な議論をしないまま履歴書をAIシステムに入力し、BAM社のハイテクな工場で働くことができる人材を探しました。その結果、いくつかの履歴書はBAM社が必要としている人材に近いというフラグが立ち、それはまさに期待通りの結果でした。

ある午後のミーティングで、Vidyaは最高執行責任者と共に採用候補者に目を通していました。「AIのおかげでそのような有能な人材を素早く見つけ出すことができたんだ。」と、Vidyaは言いました。「これについてどう思う?」

最高執行責任者は「ここにいるのは男性ばかりだ。妙だぞ。女性は応募して来なかったのかい?まるでタレントプールがおかしくなったみたいだ。」と返しました。Vidyaはすぐに異変に気づきました。

不公平でバイアスがかかったAIが、誰かに被害を及ぼしたり世間から反発されたりした例は枚挙に暇がありません。エンドユーザーたちが何らかの被害を受けるだけでなく、そのようなAIを導入した組織も、消費者からの信頼・評判の低下や関連法違反による罰則といった影響を受けてしまいます。AIに対する政府の規制は、違反した際の罰則と伴って年々厳しくなっています。

アメリカでは、連邦取引委員会(Federal Trade Commission:FTC)がAIに関連した記載をしている既存の法律の問題点を指摘し、AIの開発者やユーザーが遵守すべき事項として「開発者やユーザー自身が責任を負うこと。もしくは、FTCが代わりに責任を負う必要があるならば、その準備をしておくこと。」と発表しました2。

非常に多くのユースケースで急速にAIが使用されてきているため、現状、公平性を定義しそれを追求する責任はAIを利活用するすべての組織に求められています。

その一方で、今後検討すべき論点や倫理的な課題はいまだ数多くあり、また、それぞれのユースケースにおけるエンドユーザーへの影響は多岐にわたっており、一意に定まることはありません。

データ、開発者、システム構成など、現実世界には非常に多くの視点があり、公平なAIを開発し利活用の幅を広げるための指針はいまだ存在していないのです。

したがって、今ある法規制やガイドラインを踏まえ、組織はAIのライフサイクルのどこにバイアスが生じてしまうかを理解する必要があるのです。

では、不公平でバイアスがかかったAIの原因となる要素は何でしょうか。様々なユースケースにおける公平性はどのように評価され、対処されるべきなのでしょうか。ステークホルダは誰で、またAIを公平に活用するための手綱を握っている人物は誰なのでしょうか。

最後に、AIが持つバイアスを理解し低減させる方法を検討する出発点として、私たちはより根本的な質問をします。公平性とは何でしょうか。

2. Elisa Jillson, Aiming for Truth, Fairness, and Equity in Your Company’s Use of AI(Federal Trade Commission, April 19, 2021).