このコンテンツの続きは

無料会員の方のみご覧いただけます

無料会員の方のみご覧いただけます

登録済みの方は

会員なら

仕事に役立つ記事・動画が

無料で読み放題・見放題!

仕事に役立つ記事・動画が

無料で読み放題・見放題!

会員登録をすると

他にもこんな記事/動画が見られます

他にもこんな記事/動画が見られます

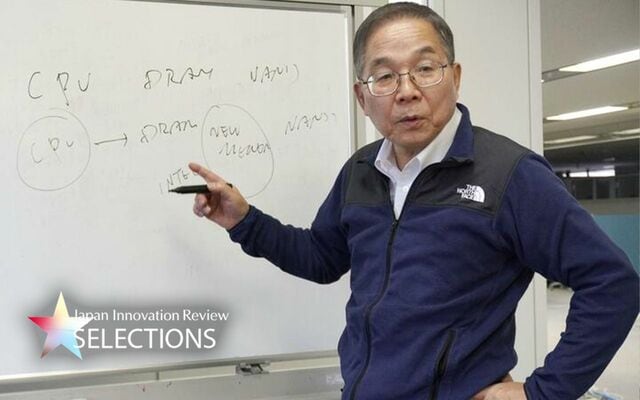

赤字続きのエルピーダを1年で黒字化、「半導体のプロ経営者」坂本幸雄氏が発揮した驚異の経営手腕とは?

「たかが社訓」ではなかった…J&Jの企業理念「クレドー」の驚くべき徹底ぶりとは?

「結果」だけでは足りない カインズ社長が語る「死の谷」で試される経営者の胆力と「いい経営者」の3つの素養とは

終身雇用のぬるま湯でふやけきった国際NGO…1.5億人の顧客を抱える組織の新リーダーが行ったシンプルな組織変革とは

会員6大特典

全記事・動画

見放題

見放題

フォロー機能

クリップ機能

記事の印刷・ダウンロード

シークレットコンテンツや限定イベント

最新

セミナー情報

セミナー情報

無料会員特典

Japan Innovation Review会員にご登録頂くと、

以下すべての機能を

すべて無料でご利用いただけます。

以下すべての機能を

すべて無料でご利用いただけます。

すべての記事・動画が見放題

無料メールマガジンも毎日届く

無料メールマガジンも毎日届く

変革リーダー必見の記事・動画がすべて無料で閲覧可能。無料のメールマガジン (平日毎日配信)で新着コンテンツを欠かさずチェックできます。

業界、特集、シリーズ/連載、企業等 すべてのコンテンツ、キーワードが

フォロー可能。

気になる情報を見逃さない

フォロー可能。

気になる情報を見逃さない

業界、特集、シリーズ、連載、企業など、気になる情報をフォローすると、 マイページで該当コンテンツの新着を確認できます。

クリップ機能で

「あとで読みたい、見たい」が簡単に

「あとで読みたい、見たい」が簡単に

「あとで読みたい、見たい」記事・動画はクリップ(保存)してマイページ内でチェックすることができます。

記事の印刷・PDFダウンロード

情報のストックや共有に活用

情報のストックや共有に活用

複数ページにまたがる記事をPDFファイルで一括ダウンロードすることができます。印刷する際にも便利です。 ※私的利用に限ります

会員限定のシークレットコンテンツや 特別イベント

会員限定のシークレットコンテンツの閲覧や、特別イベントにご参加いただけます。

豪華講師陣登壇の

最新セミナー情報が受け取れる

最新セミナー情報が受け取れる

年間80本以上開催の豪華講師陣によるDX/企業変革無料セミナーの情報を、 漏らさず入手していただくことができます。

JBpress/Japan Innovation Review主催セミナー

DXフォーラム

リテールDXフォーラム

マーケティング&セールス

イノベーションフォーラム

CXフォーラム

人的資本フォーラム

ワークスタイル改革フォーラム

採用改革フォーラム

DX人材フォーラム

ファイナンス・イノベーション

金融DXフォーラム

ものづくりイノベーション

建設DXフォーラム

物流イノベーション・フォーラム

モビリティ未来フォーラム

公共DXフォーラム

不動産DXフォーラム

取締役イノベーション

経営企画イノベーション

戦略人事フォーラム

戦略総務フォーラム

法務・知財DXフォーラム

サイバーセキュリティフォーラム

ほか

登録済みの方は