企業における重要な意思決定の過程でデータや情報を活用し、競争力を高めるアプローチである「インテリジェンス活用」が注目されている。2024年10月29日(火)から31日(木)までの三日間にかけて開催されたオンラインイベント「NRIセキュアカンファレンス/経営とセキュリティを『読み解く』~不確実性の時代に必要なインテリジェンス活用~」(主催:NRIセキュアテクノロジーズ)では、このインテリジェンス活用について、セキュリティやAIなどの観点を交えて、専門家が多角的な視座を提供した。本稿では、Day2(10月30日(水))のNRIセキュアテクノロジーズの大津 一樹氏による講演「デジタルトラスト~インテリジェンスのビジネスへの活用~」と、京都大学 法学研究科 特任教授 羽深 宏樹氏による講演「AIガバナンスの本質―情報の洪水に呑み込まれないために」のエッセンスをお届けする。

4つの切り口で捉える社会のパラダイムの変化

Day2では、はじめにNRIセキュアテクノロジーズ 戦略ITイノベーション本部 戦略企画部 エキスパートの大津 一樹氏より「デジタルトラスト~インテリジェンスのビジネスへの活用~」についての講演があった。

NRIセキュアテクノロジーズ 戦略ITイノベーション本部 戦略企画部 エキスパート 大津 一樹氏

現在の社会の変化は大きく、早く進んでいると言われるが、その変化を今回は4つの視点で整理した。その視点とは「技術」、「ビジネス」、「脅威」、「規制」だ。

「技術」においては、生成AIの台頭が挙げられる。生成AIはその技術が持つ可能性もさることながら、登場から浸透までが非常に短時間であったことも社会に大きなインパクトを与えており、今後さらなる新技術が登場した際の影響も予見させている。

「ビジネス」の視点では、複数の業態や業界が融合・連結したビジネスモデルや、デジタルの世界だけで成立するサービスが続々と誕生している。

こうした新技術の登場やビジネスモデルの変化は新たな「脅威」をもたらす。たとえば、生成AIの普及により、攻撃者にとっては標的となるポイントが増加したり、誤った使い方でこれまで考慮する必要がなかった脆弱性を取り込んでしまったりすることも起きる。また、ランサムウェアによる被害のように、デジタル被害がより大きく深刻な影響を及ぼす例も出てきている。

そして、「脅威」のようなネガティブなインパクトが大きくなると、それに対抗するための「規制」も強化される。

提供:NRIセキュアテクノロジーズ

提供:NRIセキュアテクノロジーズ拡大画像表示

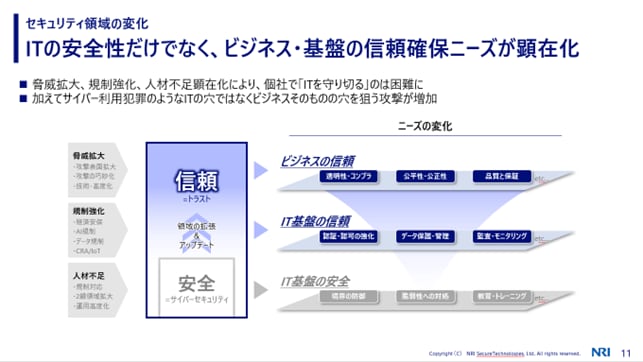

攻撃側の動向の変化を受けて、防御側である企業のガバナンスや責任体制、セキュリティに対する考え方も変化しつつある。

従来、一般的な責任体制としてCIOの配下にCISOを配置し、IT領域のセキュリティ統制を主眼に置きつつ内部監査部門も配下組織として管轄する形態が多かった。

しかし近年では、CIO(やCDO)と、CRO(やCISO)を並列に配置したり、さらにCIO(やCDO)とは別にBISO(Business Information Security Officer)を置いたりすることもある。

こうした脅威の変化、防御側企業の体制変化等の動きを俯瞰してみると、サイバーセキュリティがIT基盤の安全性を守るためのものから領域が拡張・アップデートされているのではないか。そして、それはIT基盤そのものの正当性を担保し、その上で行われるビジネスの透明性や公平性・公正性を守ることが求められているということであり、「信頼=トラスト」の担保がセキュリティ領域における特徴的な変化の一つであると考えている。

提供:NRIセキュアテクノロジーズ

提供:NRIセキュアテクノロジーズ拡大画像表示

インテリジェンス活用から生まれるインサイトにより価値を創出

インテリジェンスとは、特定のフィールドにおける情報、専門知識、動向・トレンドを指す。インテリジェンスを集約し、専門領域のエキスパートによる分析や議論、検討等を経てインサイトは導出される。このインサイトを経営に直接的に活用したり、事業を通じて間接的に活用したりすることで、ビジネス戦略の付加価値を高めることができる。ここでインテリジェンスの活用例として「デジタルクライム」への対抗法について紹介する。

「デジタルクライム」とは、悪意ある部外者がサイバーを利用して意図的に行う攻撃のことだ。昨今、デジタル決済のサービスも増えており、悪意ある部外者にとっては直接的な攻撃の機会が増え、それによる受益も増加している。エンドユーザーとのタッチポイントが多岐にわたることも制御の難しさを招き、攻撃のアプローチと正規のサービス利用との区別が難しいという課題もある。

こうした脅威に対抗するには、すでに行われている攻撃の事例を収集し分析することで、「デジタルクライム」に関するインサイトを得ることが重要だ。それが攻撃手法の類推やリスク判断に活かすことができ、被害を最小化したり、設計時にリスクを低減したりできる。これは、サービスの公平性・公正性・透明性の向上と信頼確保にも貢献する。

このように、社会の変化が大きく早く進む中で、それに適切に対応するために、短期・中長期の世の中のトレンドを適切にキャッチ・洞察し、自社の経営や事業に生かす活動、すなわち「インテリジェンスの活用」が重要となるのである。

AIと人間の共生に立ちはだかる壁

続いての講演は、京都大学 法学研究科 特任教授でスマートガバナンス 代表取締役CEO、日本・ニューヨーク州弁護士の羽深 宏樹氏による「AIガバナンスの本質―情報の洪水に呑み込まれないために」だ。

京都大学 法学研究科 特任教授 スマートガバナンス 代表取締役CEO 日本・ニューヨーク州弁護士 羽深 宏樹氏

京都大学 法学研究科 特任教授 スマートガバナンス 代表取締役CEO 日本・ニューヨーク州弁護士 羽深 宏樹氏

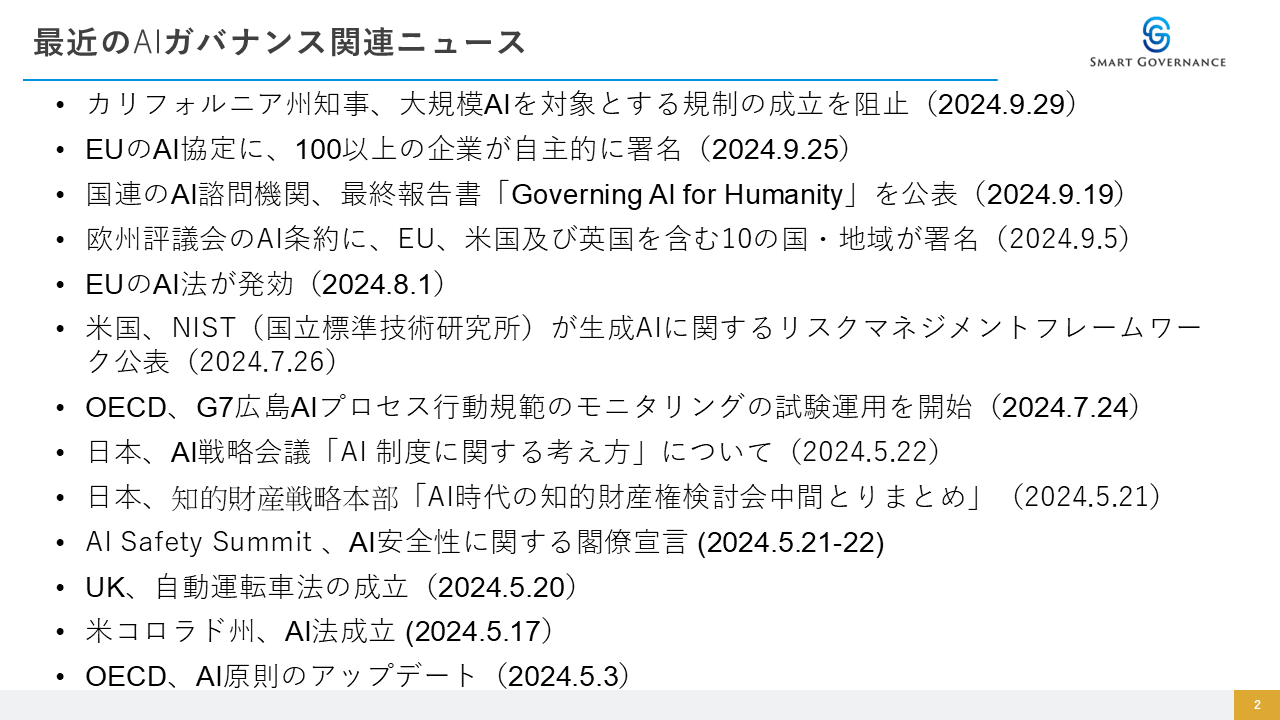

AIや、AIを含むデジタルシステムの普及は、新たに様々なリスクを生み出している。2024年6月には、イギリスのキャメロン外相が、ウクライナの前大統領の偽物とビデオ通話をしたかと思えば、8月には、アメリカのトランプ前大統領が、人気タレントが前大統領を支持しているかのようなフェイク画像をSNSでシェアした。こうした動きを受け、ここ数年、AIのリスクとどう向き合うかがグローバルなトレンドとなっている。24年8月には、EUでAI法が発効しており、9月には欧州評議会によるAI条約に、EUのほか、アメリカやイギリスを含む10の国と地域が署名をしている。

提供:羽深 宏樹氏

提供:羽深 宏樹氏拡大画像表示

日本でも、経産省と総務省によって「AI事業者ガイドライン」が取りまとめられ、責任あるAI推進基本法(仮)の成立に向けた検討が進められている。こうしたスピーディな政策形成は今後も続くものと見られる。

急速な変化への追随は、多くの企業にとって荷が重い。さらに、今後法令が整備された場合にも、企業は何をすべきで、逆に何をしてはならないのかを自ら判断しなくてはならない。抽象的な法規範をどのように解釈して、どのように自分たちのビジネスに落とし込むのかについては、企業の自主的な取り組みが期待される。そこで重要になるのが、企業によるAIガバナンスだ。

そもそもAIとは、超高性能な確率統計計算機だ。計算機という点では、これまで企業が活用してきた電卓や表計算ソフトと差がない。しかし、AIの場合、示されるのは正解ではなく正解の確率が高い解であり、かつ、その活用の場が広範にわたる。ほぼリスクを生じない場面で使われることもあれば、生命や基本的人権に関わる場面にも利用される可能性がある。すでに、過去に人間が犯したのと同じようなフェイクニュースや差別などがリスクとして指摘されている。AIによるアウトプットは様々な主体が関与した結果であることから、その責任の所在も明確になっていない。そうしたAIは今、簡単に国境を越えて利用されている。AIガバナンスは、こうしたAIの特性を踏まえたうえで取り組むべきものだ。

特化した法律がないにもかかわらず、「AI活用の環境整備の先進国」である日本

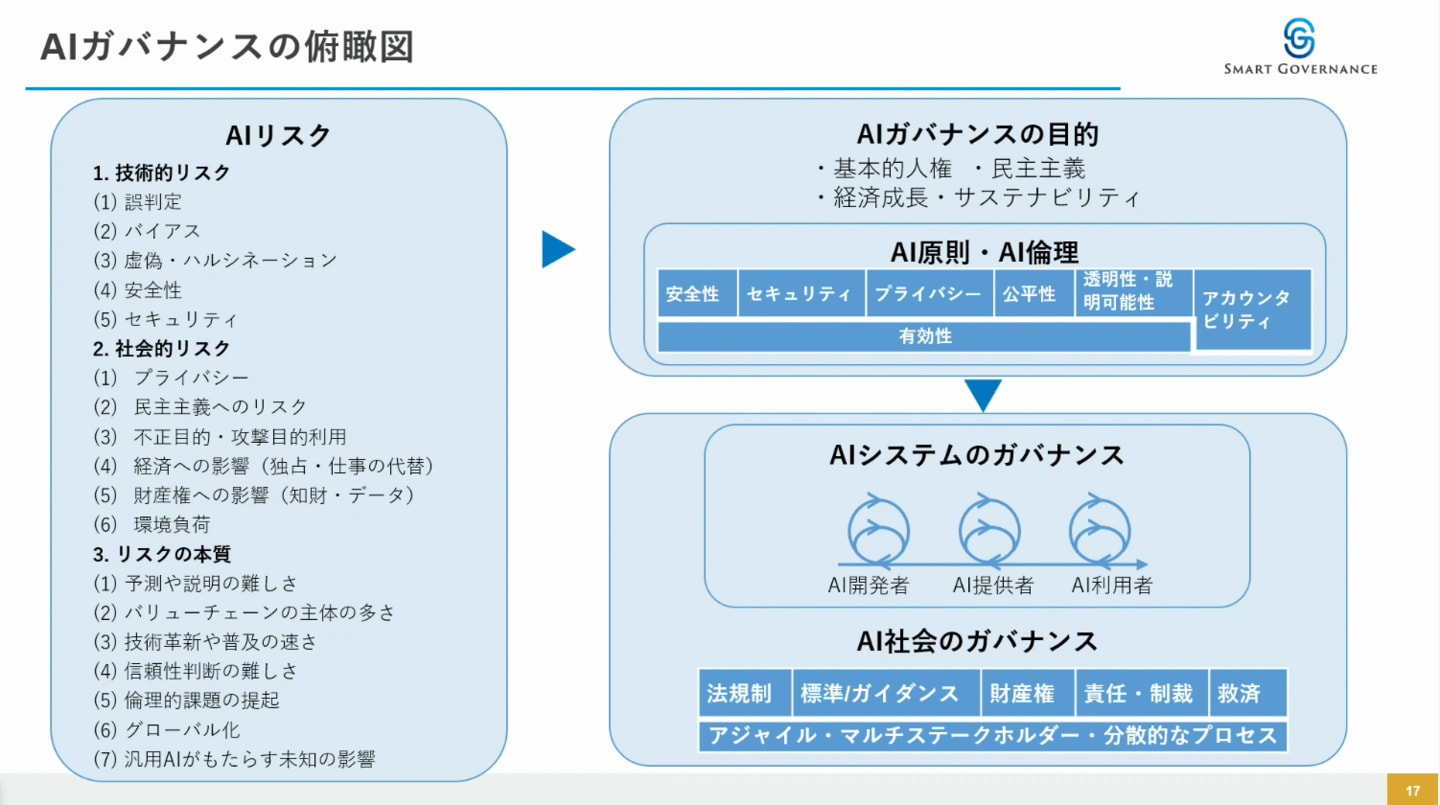

AIによるリスクは、「技術的リスク」と「社会的リスク」とに分けることができる。「技術的リスク」とは、統計と確立の機能・性能的な限界に基づくリスクだ。学習したデータが完璧である保証も、将来の事象が過去の統計分析の延長線上にあるという保証もない。ハルシネーション(AIが誤認や論理の矛盾を含む事象や事実とは異なる情報を作り出してしまう現象※)の危険性を完全に取り除くことはできない。

※NRIセキュアテクノロジーズHP(https://www.nri-secure.co.jp/glossary/hallucination)より

一方「社会的リスク」には、AIの高い分析力によって、それまでは推測できなかったような人間の好みや性格、次の行動などを高い精度で予測できてしまうリスクや、冒頭で触れたようなディープフェイクによる民主主義や国際秩序へのリスクなどが含まれる。

提供:羽深 宏樹氏

提供:羽深 宏樹氏拡大画像表示

これらのリスクをいかに管理し、AIやそれを用いるシステムのガバナンスを確保するのか。今、世界各国はこの議論を進めているところだ。EUでは、AIを包括的に規制する「AI法」が2024年8月に発効した。他方、日本では、2024年10月現在でAIを包括的に対象とした法律は存在しない。

現状は、セクターやサービス別に制定された既存の法律の中でAIへの対応が行われている。言い換えると日本では、これまでの法令を改正することでAIの普及に対応してきたということであり、これは日本の特徴と言ってもいい。たとえば、公道におけるレベル4の自動運転が可能になったのは道路運送車両法などを改訂したからであり、クレジットカード会社がAIによって与信判断できるようになったのは月賦販売法を改定したためだ。

こうした対応の結果、AIに特化した法律こそ存在しないものの、日本はAI活用にあたっての環境整備が進んだ国のひとつになっている。

提供:羽深 宏樹氏

提供:羽深 宏樹氏拡大画像表示

とはいえ、法律には「どのようなAIを使ってよいか」ということは書いていない。そのため、AIのガバナンスについては各企業が主体性をもって取り組まないといけない。これを前提にAIとそのシステムをいかにガバナンスするかを考えると、現場での日常的なフィードバックサイクルと、その外側にある、対応すべきリスクやそのための体制およびルールなど、リスクマネジメント全体の設計に関わるフィードバックサイクルの2つが必要になる。既存のAIやソフトウェアに関する国内外のリスクマネジメントのフレームワークを紐解くと、このような二重のフィードバックサイクルの構造が浮かび上がる。

そしてもう一つ重要なのは、企業が単に足元でAIに関するリスクマネジメントを行うだけではなく、その内容や結果についてステークホルダーへのアカウンタビリティを尽くすことだ。

こうしたアプローチはAIについてだけでなく、環境や人権などあらゆる領域で共通している。ステークホルダーとの協力の下で、適切かつ柔軟なガバナンスに努めることが、今後企業にはさらに求められていく。

<PR>

NRIセキュアテクノロジーズへのお問い合わせはこちら

【関連記事】

・Day1の講演(早稲田大学 教授 入山 章栄氏/NRIセキュアテクノロジーズ 代表取締役社長 建脇 俊一氏)のレポート記事はこちら

・Day3の講演(喜多羅 Chief Evangelist 喜多羅 滋夫氏/NRIセキュアテクノロジーズ 藤井 秀之氏)のレポート記事はこちら