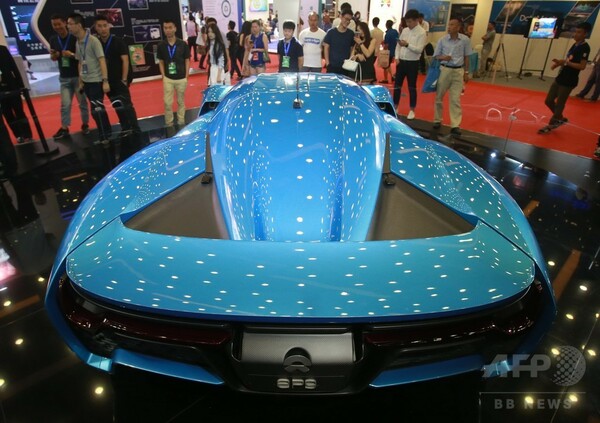

クラウドコンピューティングとビッグデータが北京に集結。写真は中国インターネット大会で展示された世界最速の電気自動車。7.1秒で速度200キロに達することができ、最高時速は323キロ(2017年7月12日撮影)。(c)CNS/陳暁根 〔AFPBB News〕

報道でAIとかIoTといった文字を見ない日はほとんどありません。いったい今回の「AIブーム」何が特徴的で何に気をつける必要があるか、もっと本質をついた解説があってもよいように思います。

そこで、私たち東京大学のグループが「知の死角」と呼んでいる問題に照準を合わせ、どのような対策が有効化を検討してみたいと思います。

初めに、五神真総長の言葉を引用して、ポイントを抜き出してみたいと思います。

ブラックボックスAIの恐怖

「近年AI技術の中で注目されている機械学習や深層学習の相当部分は、ベイズ統計という確率統計理論に依拠したもので、従来の技術とはやや異質なところがあります」

「インプットした情報からアウトプット(結論)を出すまでの計算の過程がブラックボックスになっていることと結果がステップごとの論理の積み重ねで出ているわけではないのです」(五神真「変革を駆動する大学」p.158 東京大学出版会 2017)

こんなふうにクリアに認識している人が、どれほどいるでしょうか。少なくとも東大内で学部学生に質問しても、とりわけ1~2年生なら9割方、何も分かっていないと思います。

五神東大総長の言葉を引き続き引用しつつ、このポイントを検討してみましょう。

「普通の計算機プログラムであれば、エラーが起きると、プログラマーがそれを取り除く作業をして、その積み重ねで正確なプログラムを作っていきます。(中略)先のようなAIの場合はそうではありません。AIが出した結果が正しいのかどうかは証明できないのです」

単にブラックボックスというだけでなく、今日のAIのポイントは論理的にきれいに跡づけられるケースばかりではないこと。ここに注目する必要があります。

「いまうまく機能していると思っていたとしても、全く想定しないくらい大きく間違った結論を急に出してしまう可能性がないとは言えません。(中略)実は、人間の脳も同じ意味で処理プロセスが明らかでない部分が多いにもかかわらず、人間が社会を形成しています」

そうなんですね。第2次世界大戦後、ジョン・フォン・ノイマン主導による電子計算機の発明以来、20世紀型の「人工知能」は古典的に跡づけられるロジックを用いて、いわば因果的、あるいは職人的精密加工型で演算をプログラムし、実行してきた。

あえて言えば古典力学のように一つひとつのプロセスが明確、少し難しく言うなら「ニュートン型」のクラシカルな推論が行われていた。